共计 925 个字符,预计需要花费 3 分钟才能阅读完成。

紀錄一下如何在 WSL 下配置 llama-factory

前置準備

請務必先安裝好 conda 可以參該文章配置,另外務必配置好 WSL 代理參考該文章

安裝好後,輸入下數命令添加 Python 虛擬環境並啟用

conda create -n llama-factory python=3.11

conda activate llama-factory配置 CUDA

確認 CUDA 驅動 是否配置完成如下圖 詳見

nvidia-smi根據 文檔 移除 GPG Key,文中提及默認是會安裝 CUDA 相關驅動,但沒有 Toolkit 所以下面還得手動安裝

sudo apt-key del 7fa2af80參考 官方文檔 進行安裝即可

根據命令輸入後最後安裝完成如下圖,進行測試會出現錯誤如下

配置 CUDA 路徑

先使用命令查詢如下

ls -l /usr/local/接著配置命令啟動

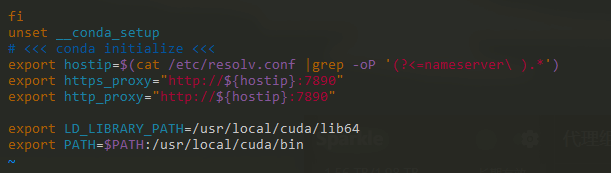

vim ~/.bashrc添加如下

export LD_LIBRARY_PATH=/usr/local/cuda/lib64

export PATH=$PATH:/usr/local/cuda/bin刷新配置接著測試如下

source ~/.bashrc配置 llama-factory

克隆 llama-factory 項目如下圖,如果速度很慢說明代理沒配置正確!

接著安裝依賴

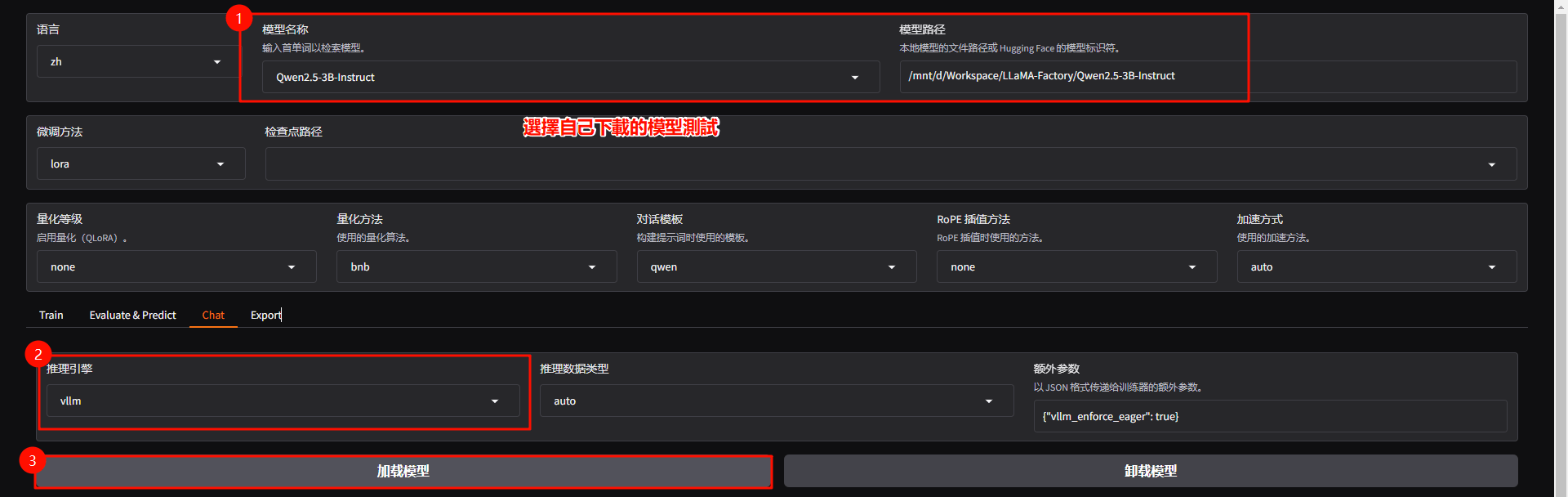

pip install -e ".[torch,metrics]"配置 vllm

如下命令,這裡建議添加鏡像地址,如果本身 WSL 配置代理可以不添加!

pip install -e ".[vllm]" -i https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/free最終驗證查看下是否都正常配置,最終輸出 True 即可

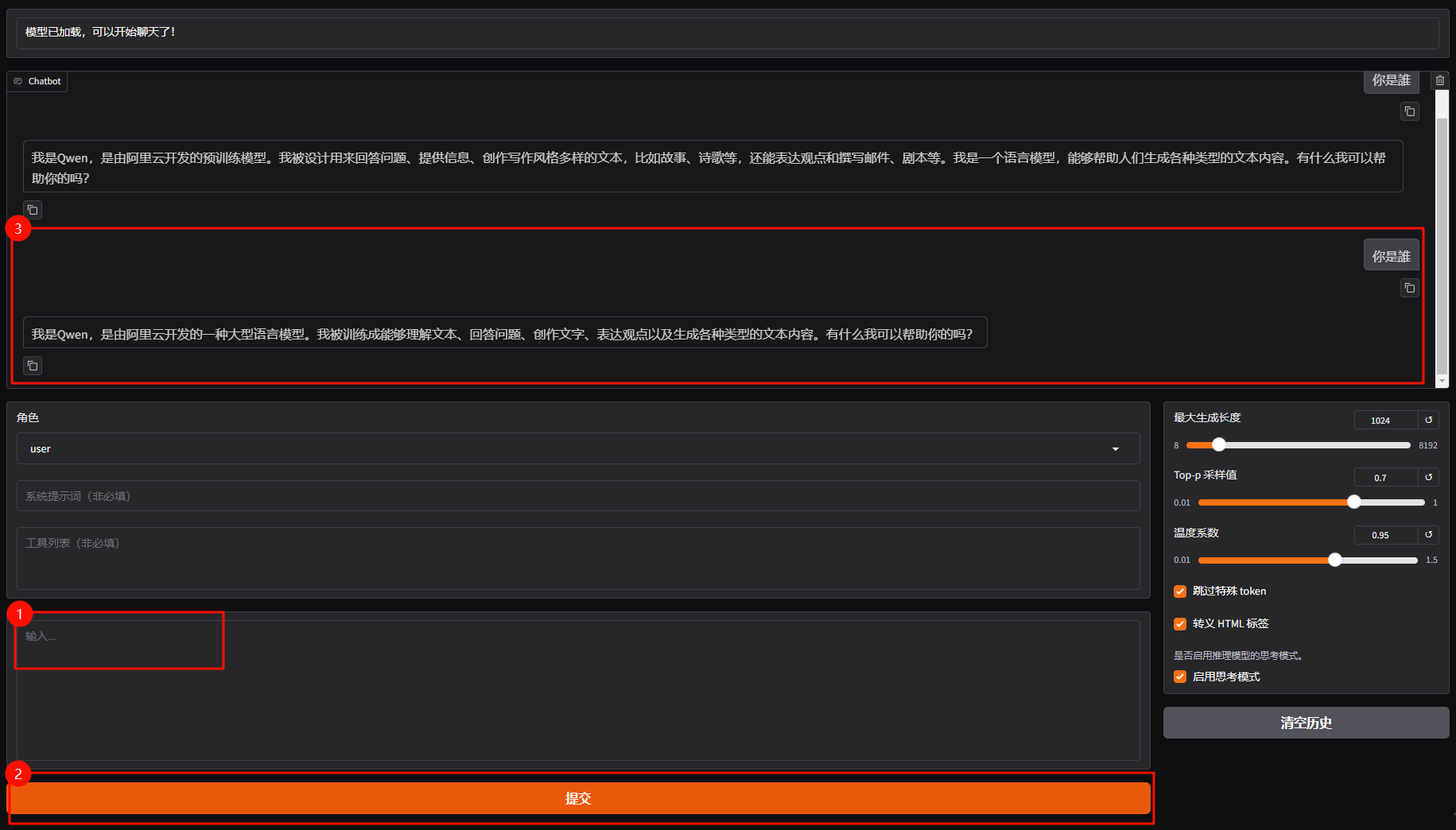

python -c "import torch; print(torch.cuda.is_available())"默認 WSL 可以直接訪問 HOST 主機,我的模型放置 D 盤所以直接 /mnt/ d 就可以訪問了

正文完