共计 794 个字符,预计需要花费 2 分钟才能阅读完成。

首次安装

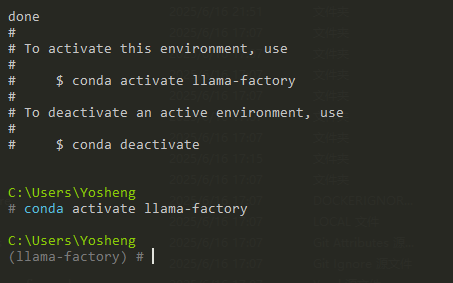

請先確認好 安裝 Conda 環境,接著輸入命令

conda create -n llama-factory python=3.11如下圖後接著輸入啟動命令

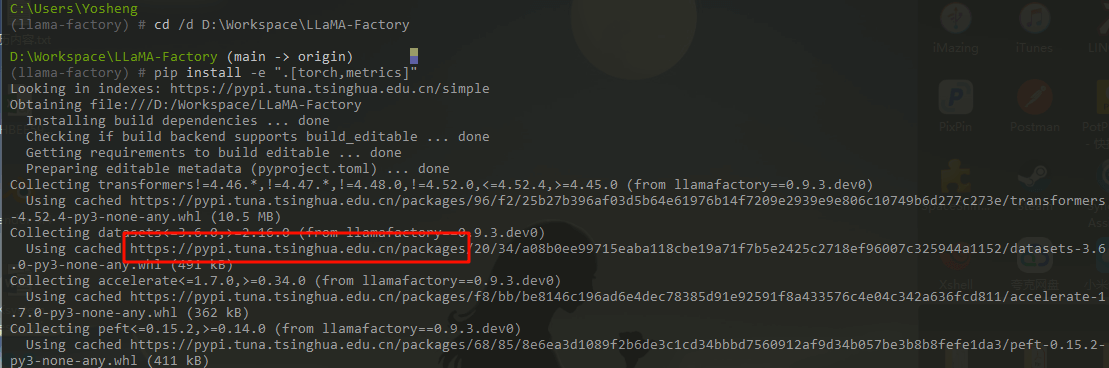

conda activate llama-factorygit clone --depth 1 https://github.com/hiyouga/LLaMA-Factory.git接著切換到下載的路徑並安裝依賴如下圖

pip install -e ".[torch,metrics]"如果你沒配置鏡像地址在境內會很慢

安裝完成如下命令啟動 WebUI

llamafactory-cli webui配置 CUDA

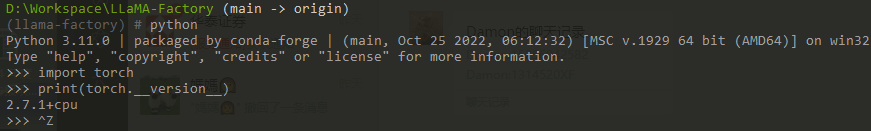

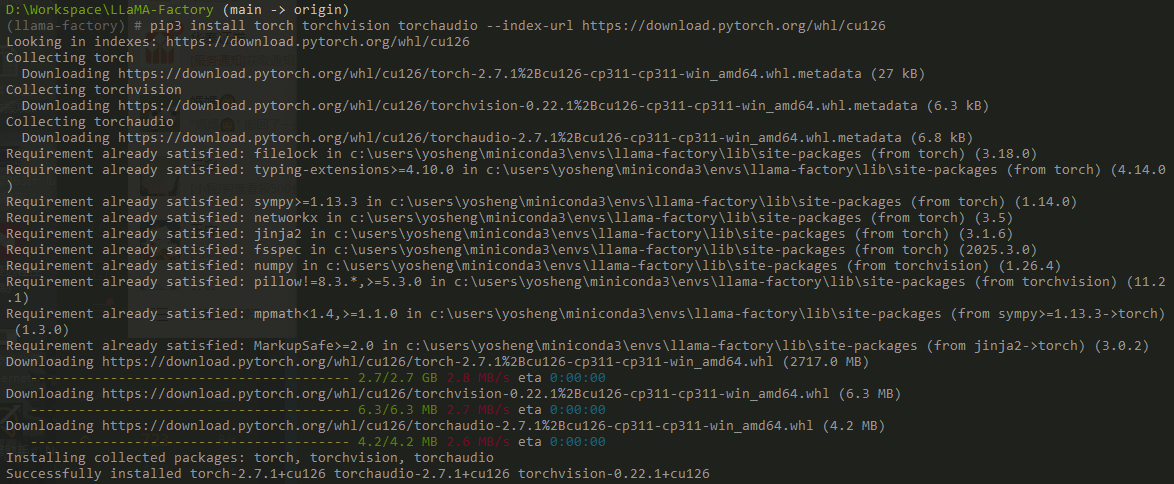

預設安裝 torch 會使用 CPU 版本,所以這裡必須自己手動重新配置 GPU 如下圖

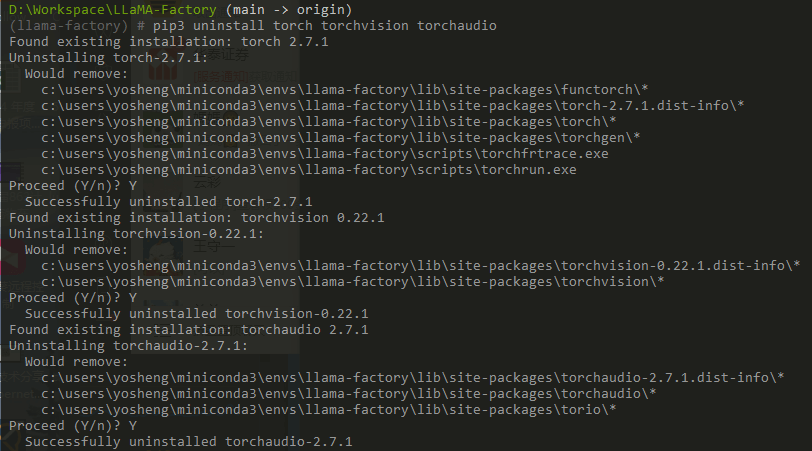

這裡我們要先手動刪除默認安裝的包

pip3 uninstall torch torchvision torchaudio接著根據自己電腦配置安裝對應的 Torch 版本,可以 參考文章

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu126最後重新驗證下

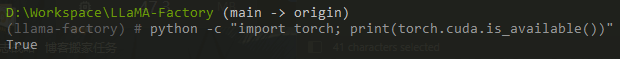

python -c "import torch; print(torch.cuda.is_available())"下載大模型

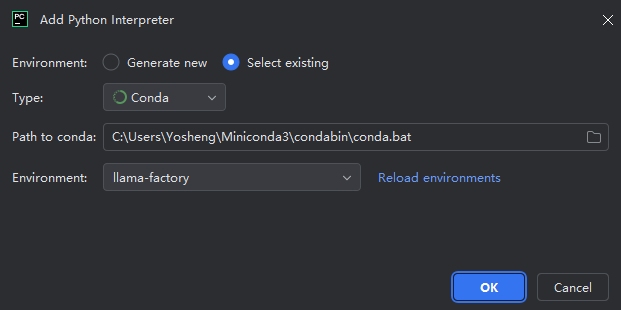

使用 PyCharm 打開 LLaMA-Factory 並參考如下配置

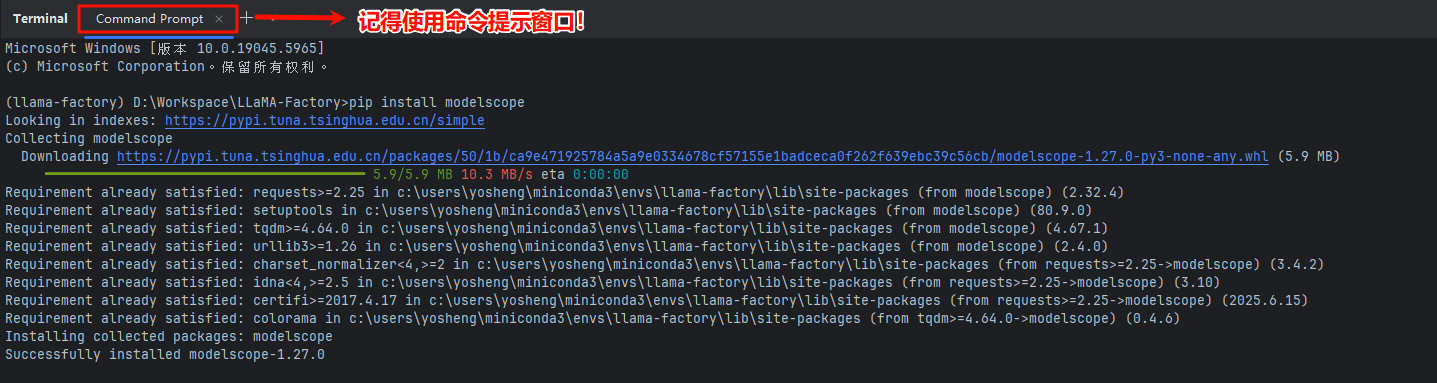

ModelScope

接着安裝 ModelScope 命令工具

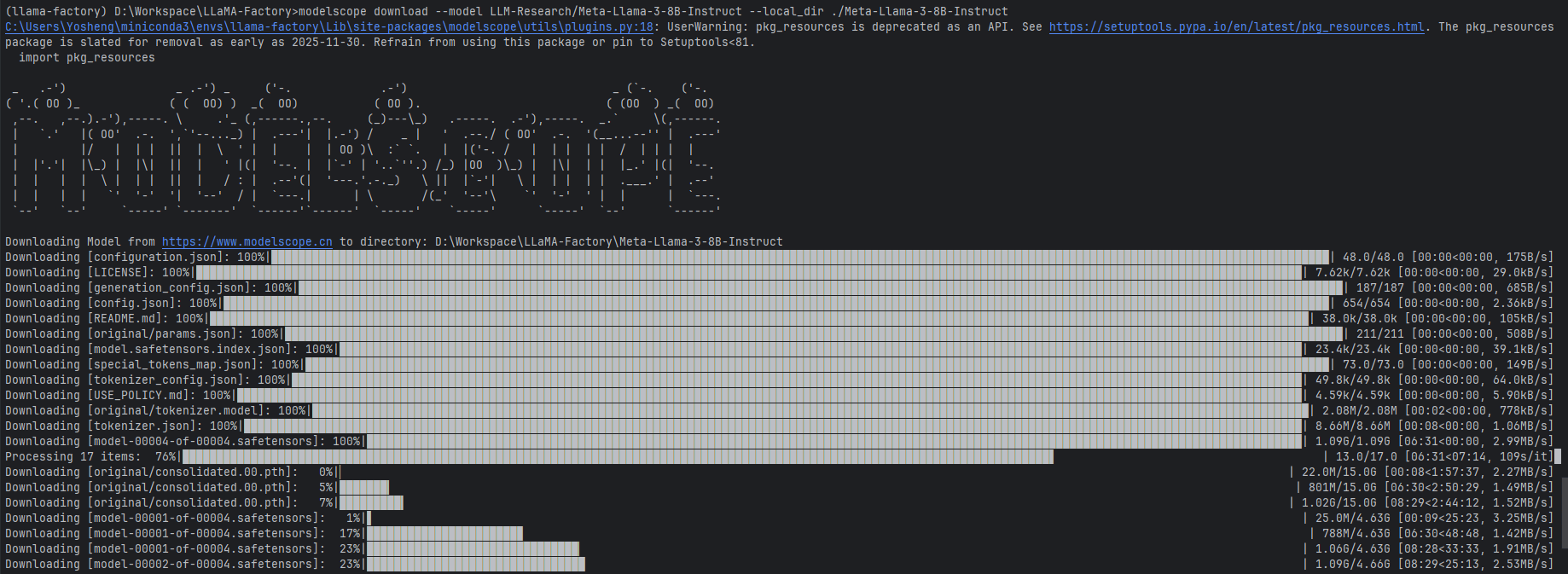

pip install modelscope下載大模型

modelscope download --model LLM-Research/Meta-Llama-3-8B-Instruct --local_dir ./Meta-Llama-3-8B-Instruct正文完